Projets pilotes de participation des boursiers postdoctoraux à l’évaluation par les pairs

Les IRSC sont déterminés à contribuer au perfectionnement de la prochaine génération de chercheurs en santé en accélérant leur autonomie et leur leadership scientifiques. Comme le développement de compétences en évaluation par l’expérience pratique constitue une part importante du perfectionnement professionnel des chercheurs émergents, les IRSC ont décidé de stimuler ce développement en invitant les boursiers postdoctoraux à jouer le rôle d’évaluateur pour les concours de bourses de recherche au doctorat (BRD).

Ces projets pilotes ont pour objectifs :

- de permettre aux boursiers postdoctoraux d’acquérir des compétences en évaluation par les pairs;

- d’évaluer les compétences des boursiers postdoctoraux à titre de pairs évaluateurs dans le cadre du programme de BRD;

- de déterminer le meilleur moyen de permettre aux boursiers postdoctoraux d’acquérir de l’expérience et des compétences en évaluation par les pairs, y compris les besoins en nouvelles ressources d’apprentissage.

Deux projets pilotes ont été menés durant les concours de BRD 2016 et 2017.

- Le premier projet pilote a généré des données sur le travail des boursiers postdoctoraux Banting en tant qu’évaluateurs dans le cadre du concours de BRD 2016. Dans l’ensemble, les résultats indiquent que les boursiers postdoctoraux qui ont été offerts la formation en évaluation ont servi d’évaluateurs appropiés. De plus, d’après notre sondage de suivi, les participants pensent que l’expérience leur servira dans leur carrière. Les résultats détaillés sont présentés plus bas.

- L’envergure du deuxième projet pilote a été revue pour inclure les boursiers Banting et les boursiers des IRSC qui avaient agi à titre d’évaluateurs dans le cadre du concours de BRD 2017. Un peu comme les résultats du projet pilote 1, ceux du projet pilote 2 ont révélé que les boursiers postdoctoraux sont de bons évaluateurs. De plus, d’après notre sondage de suivi, les participants estiment que l’expérience leur servira dans leur carrière. Les résultats détaillés sont présentés ci-après.

Projets pilotes 1 et 2 de participation des boursiers postdoctoraux à l’évaluation par les pairs

Méthodes

Groupes d’évaluateurs : Conformément au processus d’évaluation du concours de BDR, chaque demande a été analysée par deux évaluateurs. Chacun des projets pilotes avait deux groupes d’évaluateurs : un groupe d’évaluateurs habituels-habituels exclusivement formé d’évaluateurs expérimentés, et un groupe d’évaluateurs boursiers postdoctoraux-habituels formé d’un boursier postdoctoral et d’un évaluateur ayant plus de deux ans d’expérience. Dans le groupe d’évaluateurs boursiers postdoctoraux-habituels, une demande ne pouvait être attribuée qu’à un seul boursier.

Participation des évaluateurs : En tout, 1 175 et 1 205 demandes ont été reçues dans le cadre des concours de BRD 2016 et 2017, respectivement. Un total de 238 évaluateurs, dont 47 boursiers postdoctoraux Banting, ont participé au projet pilote 1 (concours de BRD 2016). Un total de 250 évaluateurs, dont 50 boursiers postdoctoraux (23 boursiers Banting et 27 boursiers des IRSC), ont participé au projet pilote 2 (concours de BRD 2017). Dans les deux projets pilotes, les boursiers postdoctoraux ont reçu la formation standard en évaluation par les pairs offerte à tous les évaluateurs.

| Projet pilote 1 (concours de BRD 2016) |

Projet pilote 2 (concours de BRD 2017) |

|

|---|---|---|

| Nombre total de demandes | 1175 | 1205 |

| Nombre total d’évaluateurs | 238 | 250 |

| Nombre d’évaluateurs habituels | 191 | 200 |

| Nombre d’évaluateurs boursiers postdoctoraux (BPB, MFE) | 47 | 50 (23, 27) |

| Pourcentage d’évaluateurs boursiers postdoctoraux | 20 % | 20 % |

BPB = boursiers postdoctoraux Banting |

||

Le taux de réussite des concours de BRD 2016 et 2017 était 13 %.

Charge de travail des évaluateurs : Dans le cadre du projet pilote 1, les deux types d’évaluateurs (habituels ou boursiers postdoctoraux) ont évalué en moyenne 10 demandes. Dans le cadre du projet pilote 2, les évaluateurs habituels ont évalué en moyenne 10 demandes, comparativement à une moyenne de 9 demandes pour les boursiers participants.

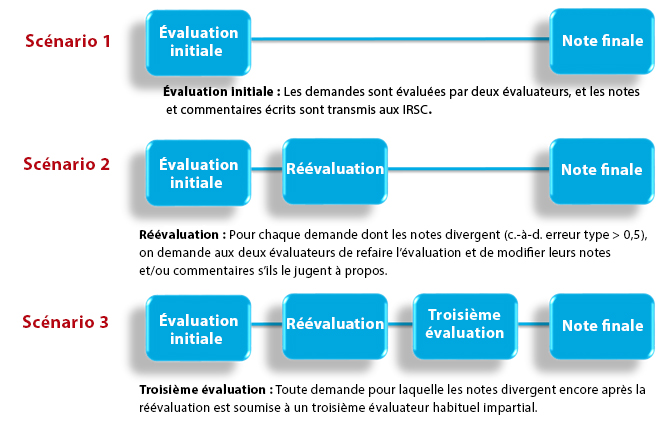

Étapes de l’évaluation : L’évaluation des demandes soumises dans le cadre du concours de BRD peut comprendre jusqu’à trois étapes, selon l’importance de l’écart entre les notes attribuées par les deux évaluateurs.

Figure 1 : Les trois étapes possibles de l’évaluation des demandes de BRD, selon les notes attribuées par les évaluateurs. Les projets pilotes ont été menés selon le même processus d’évaluation à trois étapes.

Figure 1 – Description détaillée

Processus d’évaluation du concours de BRD. L’évaluation des demandes soumises dans le cadre du concours de BRD peut comprendre jusqu’à trois étapes, selon l’importance de l’écart entre les notes attribuées par les deux évaluateurs.

- Évaluation initiale : Les demandes sont évaluées, et les notes et commentaires écrits sont retournés aux IRSC.

- Réévaluation : Pour chaque demande dont les notes divergent (c.-à-d. écart ˃ 0,5), les deux évaluateurs sont invités à refaire l’évaluation et à modifier leurs notes et/ou commentaires s’ils le jugent à propos.

- Troisième évaluation : Toute demande pour laquelle les notes divergent encore après la réévaluation est soumise à un troisième évaluateur habituel impartial.

Le groupe d’évaluateurs habituels-habituels et le groupe de boursiers postdoctoraux-habituels ont tous deux pris part à toutes les étapes de l’évaluation. Dans les cas de réévaluation, les boursiers ont été encouragés à s’adresser à leurs mentors désignés (possédant au moins deux années d’expérience comme évaluateur pour les BRD) et/ou au personnel des IRSC s’ils avaient des questions. Dans les cas où la réévaluation n’a pas permis de résoudre la divergence des notes, le troisième évaluateur était toujours un évaluateur expérimenté.

À la fin de chaque projet pilote, les évaluateurs habituels et les boursiers participants ont été invités à remplir un sondage sur leur expérience globale. Les recommandations tirées des résultats du sondage sur le projet pilote 1 ont servi de fondement aux documents de formation du projet pilote 2 et ont été mises en œuvre.

Résultats

Les IRSC ont analysé les données des concours de BRD 2016 et 2017 pour comparer le comportement d’évaluation des évaluateurs boursiers postdoctoraux à celui des évaluateurs habituels. L’analyse a été effectuée à chacune des trois étapes de l’évaluation. Le tableau 2 présente les types d’analyses effectuées. Les résultats du sondage ont été analysés séparément. Pour le projet pilote 1, une analyse qualitative additionnelle a été menée pour comparer la qualité des évaluations.

| A. Analyse quantitative par étape de l’évaluation (projets pilotes 1 et 2) | ||

|---|---|---|

| Description du concours de BRD | Analyse effectuée | |

| 1. Évaluation initiale | Les demandes sont évaluées, et les cotes et les commentaires écrits sont transmis aux IRSC. |

|

| 2. Réévaluation | Pour chaque demande dont les notes divergent (c.-à-d. écart ˃ 0,5), les deux évaluateurs sont invités à refaire l’évaluation et à modifier leurs notes et/ou commentaires s’ils le jugent à propos. |

|

| 3. Troisième évaluation | Pour toute demande dont les notes divergent encore après la réévaluation, les IRSC demandent à un troisième évaluateur habituel impartial d’évaluer et de noter la demande. |

|

| B. Analyse qualitative (projet pilote 1 seulement) | ||

| 4. Comparaison de la qualité (rigueur et utilité) des évaluations écrites des évaluateurs | ||

| C. Analyse des résultats du sondage (projets pilotes 1 et 2) | ||

| 5. Analyse des rétroactions des évaluateurs | ||

-

A. Comparaison de la notation des évaluateurs – Analyse quantitative

Le tableau 3 présente le nombre de demandes assignées à chaque groupe d’évaluateurs et la proportion de demandes soumises à chacune des étapes de l’évaluation menées par chaque groupe d’évaluateurs dans les deux projets pilotes.

Projet pilote 1 Projet pilote 2 Groupes d’évaluateurs Habituels-habituels Boursiers-habituels

(boursiers = BPB)

Habituels-habituels Boursiers-habituels

(boursiers = MFE + BPB)

Nombre de demandes évaluées 683 492 740 465 Nombre (%) de demandes ayant fait l’objet d’une réévaluation 42

(6 %)26

(5 %)55

(7 %)22

(5 %)Nombre (%) de demandes ayant fait l’objet d’une troisième évaluation 12

(2 %)13

(3 %)12

(1,6 %)1

(0,2 %)Évaluation initiale

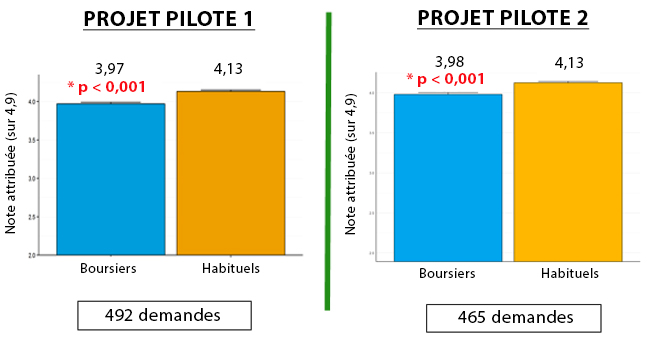

Figure 2 : Comparaison des notes pondérées moyennes attribuées aux demandes communes par les évaluateurs habituels et les évaluateurs boursiers. Dans les deux projets pilotes, les évaluateurs boursiers postdoctoraux ont attribué des notes plus faibles lors de l’évaluation initiale que les évaluateurs habituels (p < 0,001).

Figure 2 – Description détaillée

Comparaison des notes pondérées moyennes attribuées aux demandes communes par les évaluateurs habituels et les évaluateurs boursiers. Dans les deux projets pilotes, les évaluateurs boursiers postdoctoraux ont attribué des notes modérées lors de l’évaluation initiale, comparativement aux évaluateurs habituels (p < 0,001). Des tests t d’échantillons appariés ont été effectués pour comparer les notes attribuées par les évaluateurs boursiers postdoctoraux à celles attribuées par les évaluateurs habituels pour les demandes communes.

- En moyenne, les 492 demandes examinées par le groupe d’évaluateurs habituels-boursiers postdoctoraux dans le cadre du projet pilote 1 ont reçu une note de 3,97 des évaluateurs boursiers et de 4,13 des évaluateurs habituels. Cette différence de 0,16 est statistiquement significative (p < 0,001).

- En moyenne, les 465 demandes examinées par le groupe d’évaluateurs habituels-boursiers postdoctoraux dans le cadre du projet pilote 2 ont reçu une note de 3,98 des évaluateurs boursiers et de 4,13 des évaluateurs habituels. Cette différence de 0,15 est statistiquement significative (p < 0,001).

Projet pilote 1

(492 demandes)Projet pilote 2

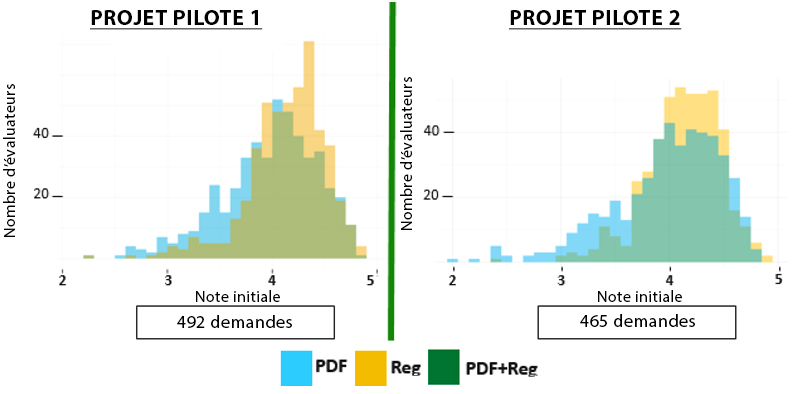

(465 demandes)Boursiers Habituels Boursiers Habituels Note pondérée moyenne 3,97 4,13 3,98 4,13 Erreur type 0,02 0,02 0,02 0,02 Figure 3 : Comparaison de la distribution des notes attribuées aux demandes communes par les évaluateurs boursiers et les évaluateurs habituels. Les notes attribuées par les évaluateurs boursiers postdoctoraux couvrent une plus grande partie de la plage de notation, conformément au guide de l’évaluateur. En général, la notation des boursiers postdoctoraux correspond à celle des évaluateurs habituels.

Figure 3 – Description détaillée

Les barres vertes indiquent la correspondance entre les notes données par les deux types d’évaluateurs. Les notes attribuées par les évaluateurs boursiers postdoctoraux (bleu) concordent bien avec les notes attribuées par les évaluateurs habituels (jaune).

- Dans le cadre du projet pilote 1, les évaluateurs des deux types ont donné une note entre 3,8 et 4,2 à un nombre comparable de demandes. Toutefois, les évaluateurs boursiers ont accordé plus de notes inférieures à 3,8, et les évaluateurs habituels, plus de notes supérieures à 4,2.

- Dans le cadre du projet pilote 2, les évaluateurs des deux types ont donné une note entre 3,8 et 4,2 à un nombre comparable de demandes. Toutefois, les évaluateurs boursiers ont donné plus de notes inférieures à 3,8, et les évaluateurs habituels, plus de notes supérieures à 4,0.

Réévaluation

Dans le cas d’une divergence de 0,5 (erreur type) des notes attribuées par les deux évaluateurs, les IRSC demandent à chacun de réévaluer la note qu’il a attribuée.

Proportion des demandes : Comme dans les deux projets pilotes, les paires d’évaluateurs boursiers postdoctoraux-habituels avaient moins de demandes nécessitant une réévaluation [projet pilote 1 : 5 % (boursiers postdoctoraux-habituels) vs 6 % (habituels-habituels); projet pilote 2 : 5 % (boursiers postdoctoraux-habituels) vs 7 % (habituels-habituels), non significatif], ce qui révèle que la notation était comparable chez les évaluateurs boursiers postdoctoraux et les évaluateurs d’expérience. Voir le tableau 3 ci-dessus.

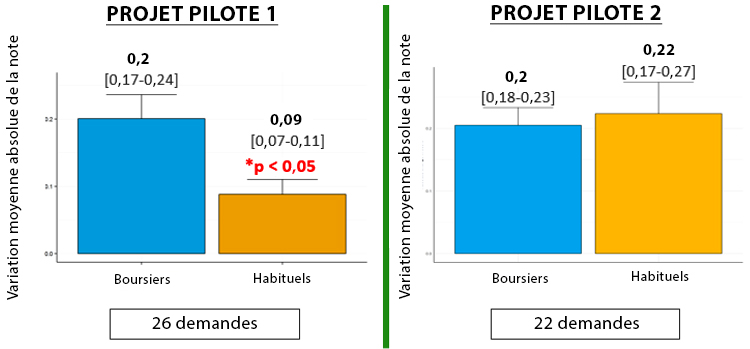

Flexibilité quant à la notation : Pour ce qui est de réviser la note attribuée à une demande lors de la réévaluation, les évaluateurs boursiers postdoctoraux du projet pilote 1 ont modifié dans une plus large mesure la note initiale, comparativement aux évaluateurs habituels (p < 0,05). Dans le projet pilote 2, les boursiers postdoctoraux ont montré une flexibilité comparable à celle des évaluateurs habituels.

Figure 4 : Comparaison entre les évaluateurs boursiers postdoctoraux et les évaluateurs habituels quant à la variation absolue des notes attribuées aux demandes communes nécessitant une réévaluation.

Figure 4 – Description détaillée

- Projet pilote 1 : Pour les 26 demandes communes ayant fait l’objet d’une réévaluation, les évaluateurs boursiers postdoctoraux ont modifié dans une plus large mesure la note initiale que les évaluateurs habituels (variation absolue moyenne de 0,2 pour les boursiers et de 0,09 pour les évaluateurs habituels, p < 0,05).

- Projet pilote 2 : Pour les 22 demandes communes ayant fait l’objet d’une réévaluation, les évaluateurs boursiers postdoctoraux ont modifié la note initiale de façon comparable aux évaluateurs habituels (variation absolue moyenne de 0,2 pour les boursiers et de 0,22 pour les évaluateurs habituels, p < 0,05). Aucune variation significative n’a été observée entre la note moyenne initiale et la note attribuée lors de la réévaluation par l’un ou l’autre type d’évaluateur.

Les barres d’erreur représentent l’erreur type de la moyenne. Des tests t d’échantillons appariés ont été effectués pour comparer les notes initiales et les notes attribuées lors de la réévaluation.

Troisième évaluation

Dans les cas où la réévaluation n’a pas permis de résoudre la divergence des notes, les IRSC ont demandé à un troisième évaluateur impartial (toujours un évaluateur expérimenté) d’évaluer et de noter la demande.

Proportion de demandes : Les boursiers postdoctoraux se sont révélés compétents comme pairs évaluateurs dans les deux projets pilotes. Dans le cadre du projet pilote 1, la performance des paires d’évaluateurs boursiers postdoctoraux-habituels était comparable à celle des paires d’évaluateurs habituels-habituels [3 % (boursiers postdoctoraux-habituels) vs 2 % (habituels-habituels); différence non significative]. Dans le cadre du projet pilote 2, la performance des paires d’évaluateurs boursiers postdoctoraux-habituels a connu une amélioration significative quant à la proportion de demandes exigeant un troisième évaluateur (* p < 0,05). Fait notable, une seule demande a fait l’objet d’une troisième évaluation dans le groupe d’évaluateurs boursiers postdoctoraux-habituels, tandis que 12 demandes ont nécessité une troisième évaluation dans le groupe d’évaluateurs habituels-habituels [0,2 % (boursiers postdoctoraux-habituels) vs 1,6 % (habituels-habituels) : p < 0,05] (voir le tableau 2).

Comparaison des notations : Notes moyennes attribuées par les évaluateurs boursiers postdoctoraux et les évaluateurs habituels vs notes attribuées par les troisièmes évaluateurs : Cette analyse n’a pu être effectuée que dans le cadre du projet pilote 1 étant donné qu’une seule demande évaluée par des boursiers postdoctoraux a fait l’objet d’une troisième évaluation dans le cadre du projet pilote 2.

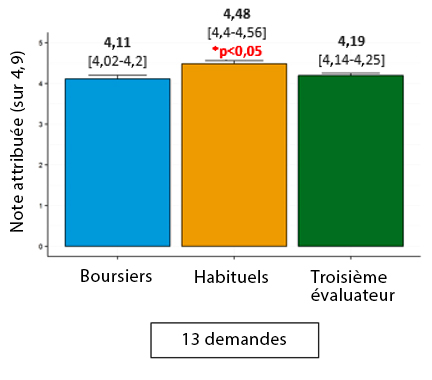

Figure 5 : Comparaison de la note moyenne attribuée aux demandes communes par les évaluateurs boursiers et les évaluateurs habituels (à la réévaluation) et par les troisièmes évaluateurs (projet pilote 1 seulement).

Figure 5 – Description détaillée

Description détaillée de la figure 5 :

- Dans le cadre du projet pilote 1, les notes attribuées lors de la réévaluation effectuée par les boursiers postdoctoraux étaient plus proches des notes attribuées par le troisième évaluateur que les notes attribuées lors de la réévaluation par les évaluateurs habituels. Pour les demandes initialement évaluées par un boursier qui ont ensuite fait l’objet d’une troisième évaluation (n = 13), la note moyenne attribuée par le troisième évaluateur (4,19) était significativement inférieure à celle attribuée par les évaluateurs habituels à l’étape de réévaluation (4,48; p < 0,05), mais pas significativement différente de celle attribuée par les évaluateurs boursiers à cette même étape (4,11; p > 0,05).

- Étant donné qu’une seule demande évaluée par des boursiers postdoctoraux a fait l’objet d’une troisième évaluation dans le cadre du projet pilote 2, la taille du groupe était insuffisante et ne permettait donc pas d’effectuer une analyse statistique.

-

B. Comparaison de la qualité de l’évaluation – Analyse qualitative des commentaires écrits des évaluateurs (projet pilote 1 seulement)

Le Guide de l’évaluateur pour les bourses de recherche au doctorat des IRSC demande aux pairs évaluateurs d’axer leurs commentaires écrits destinés aux candidats « sur les forces et les faiblesses liées à chaque critère de sélection ». D’après l’Aide-mémoire pour assurer la qualité de l’évaluation du collège des évaluateurs, la qualité de l’évaluation dépend de trois facteurs : 1) son caractère approprié; 2) sa rigueur; et 3) son utilité. Les IRSC ont donc comparé les commentaires formulés par les évaluateurs boursiers et les évaluateurs habituels en ce qui concerne :

- leur rigueur, définie comme le nombre de mots qu’ils contiennent, la couverture de tous les critères de sélection préétablis (voir figure 6) et la mise en évidence des forces et des faiblesses;

- leur utilité, définie comme la présence de conseils.

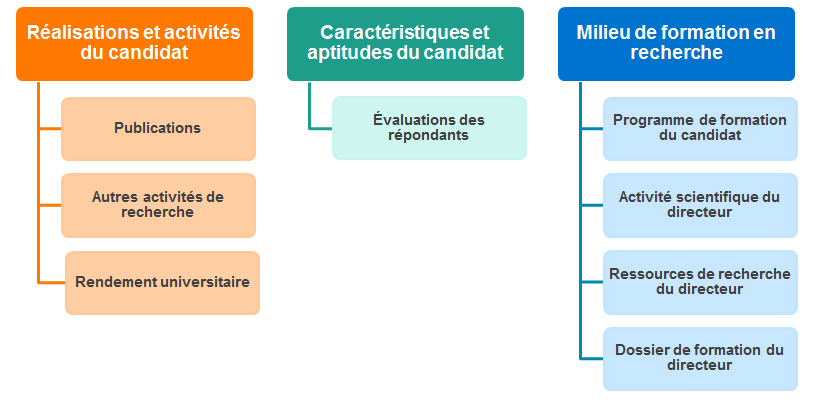

La figure 6 énonce les critères et sous-critères de sélection applicables aux bourses de recherche au doctorat.

Description détaillée de la figure 6

Les demandes de BRD sont actuellement étudiées par des évaluateurs selon trois critères de sélection prédéfinis, présentés ci-dessous avec leurs sous-critères respectifs.

- Réalisations et activités du candidat. Ce critère se subdivise en trois sous-critères : 1) publications; 2) autres activités de recherche; 3) rendement universitaire.

- Milieu de formation en recherche. Ce critère se subdivise en trois sous-critères : 1) programme de formation du candidat; 2) activité scientifique du directeur; 3) ressources de recherche du directeur; 4) dossier de formation du directeur.

- Caractéristiques et aptitudes du candidat. Ce critère est évalué en fonction des évaluations des répondants.

Le Guide de l’évaluateur pour les bourses de recherche au doctorat des IRSC présente tous les détails concernant les critères de sélection.

L’analyse qualitative portait sur 70 demandes acceptées et refusées choisies au hasard qui :

- avaient été attribuées au groupe d’évaluateurs habituels-boursiers postdoctoraux;

- avaient été examinées par le comité d’évaluation par les pairs du domaine biomédical;

- n’ont pas fait l’objet d’une réévaluation ou d’une troisième évaluation.

Caractéristiques de l’échantillon

Le tableau 4 indique le nombre d’évaluateurs habituels et d’évaluateurs boursiers qui ont évalué au moins une des 35 demandes acceptées et 35 demandes refusées de l’échantillon.

Demandes acceptées (N = 35) Demandes refusées (N = 35) Évaluateurs habituels Évaluateurs boursiers Évaluateurs habituels Évaluateurs boursiers Nombre d’évaluateurs 26 20 30 23 Nombre total d’évaluateurs 46 53 Nombre d’évaluateurs 35 35 35 35 Nombre total d’évaluations 70 70 A. Rigueur

Critère 1 : Nombre de mots

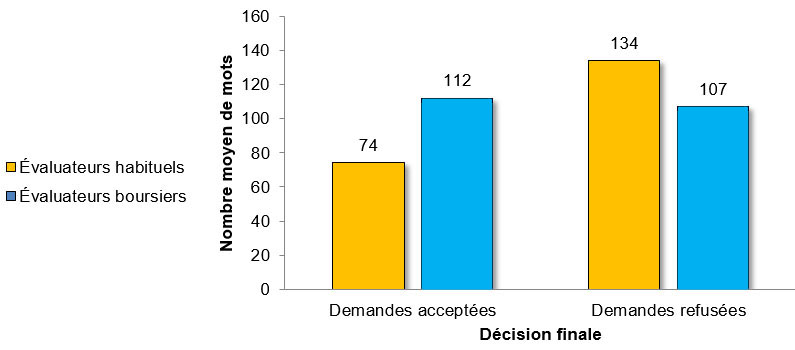

La figure 7 illustre le nombre moyen de mots des commentaires formulés par les évaluateurs habituels et les évaluateurs boursiers, pour les demandes acceptées et refusées.

Description détaillée de la figure 7

Comparaison du nombre de mots moyen, minimal et maximal des commentaires formulés par les évaluateurs habituels et les évaluateurs boursiers, pour les demandes acceptées et refusées.

Demandes acceptées Demandes refusées Évaluateurs habituels Évaluateurs boursiers Évaluateurs habituels Évaluateurs boursiers Moyenne 74 112 134 107 Minimum 0 0 0 0 Maximum 291 336 606 546 Critère 2 : Couverture des critères de sélection préétablis

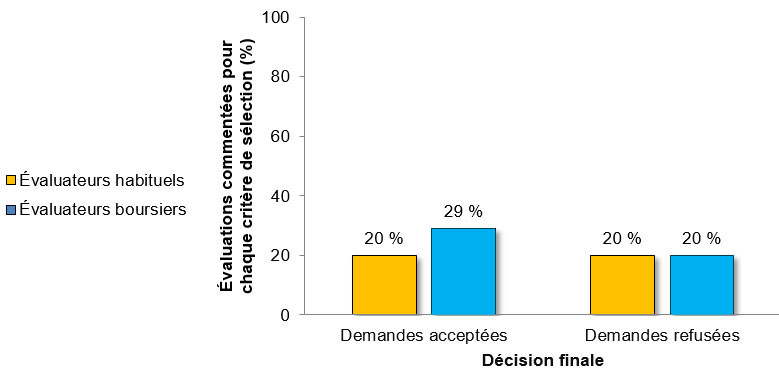

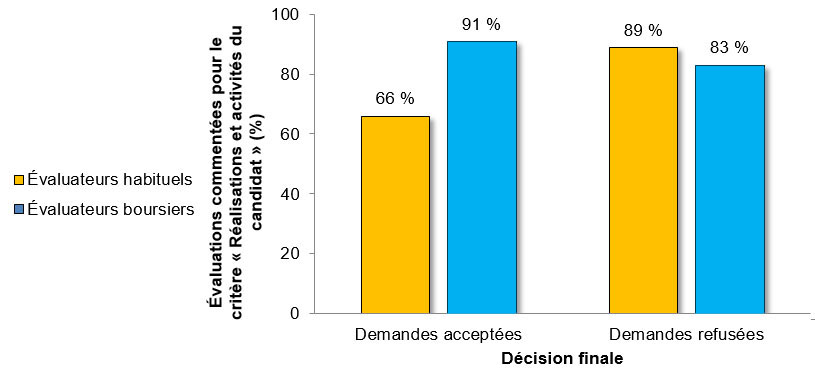

La figure 8 indique le pourcentage des évaluations au cours desquelles les évaluateurs habituels et les évaluateurs boursiers ont formulé des commentaires relativement à chaque critère de sélection applicable aux BRD, pour les demandes acceptées et refusées.

Description détaillée de la figure 8

Nombre d’évaluations réalisées par les évaluateurs habituels et les évaluateurs boursiers dans lesquelles on retrouve des commentaires pour chaque critère de sélection applicable aux BRD, pour les demandes acceptées et refusées, et pourcentage que représentent ces évaluations dans leur catégorie.

Demandes acceptées Demandes refusées Évaluateurs habituels (N = 35) Évaluateurs boursiers (N = 35) Évaluateurs habituels (N = 35) Évaluateurs boursiers (N = 35) Nombre d’évaluations concernées 7 10 7 7 % de leur catégorie 20 % 29 % 20 % 20 % La figure 9 indique le pourcentage des évaluations dans lesquelles les évaluateurs habituels et les évaluateurs boursiers ont formulé des commentaires relativement au critère « Réalisations et activités du candidat », pour les demandes acceptées et refusées.

Description détaillée de la figure 9

Nombre d’évaluations réalisées par les évaluateurs habituels et les évaluateurs boursiers dans lesquelles on retrouve des commentaires sur le critère « Réalisations et activités du candidat », pour les demandes acceptées et refusées, et pourcentage que représentent ces évaluations dans leur catégorie.

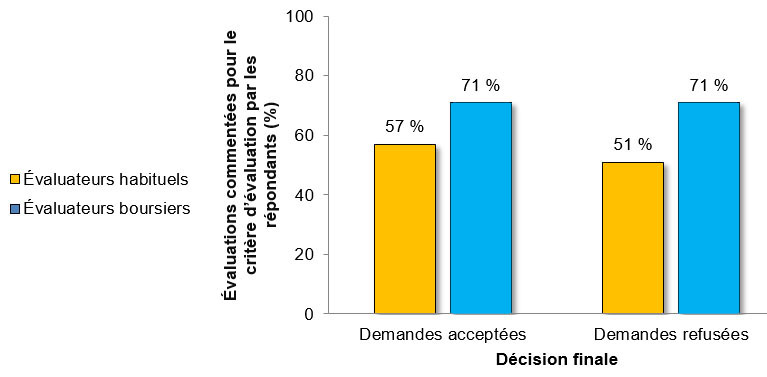

Demandes acceptées Demandes refusées Évaluateurs habituels (N = 35) Évaluateurs boursiers (N = 35) Évaluateurs habituels (N = 35) Évaluateurs boursiers (N = 35) Nombre d’évaluations concernées 23 32 31 29 % de leur catégorie 66 % 91 % 89 % 83 % La figure 10 indique le pourcentage des évaluations des lesquelles les évaluateurs habituels et les évaluateurs boursiers ont formulé des commentaires relativement au critère d’évaluation par les répondants, pour les demandes acceptées et refusées.

Description détaillée de la figure 10

Nombre d’évaluations réalisées par les évaluateurs habituels et les évaluateurs boursiers dans lesquelles on retrouve des commentaires pour le critère d’évaluation par les répondants, pour les demandes acceptées et refusées, et pourcentage que représentent ces évaluations dans leur catégorie.

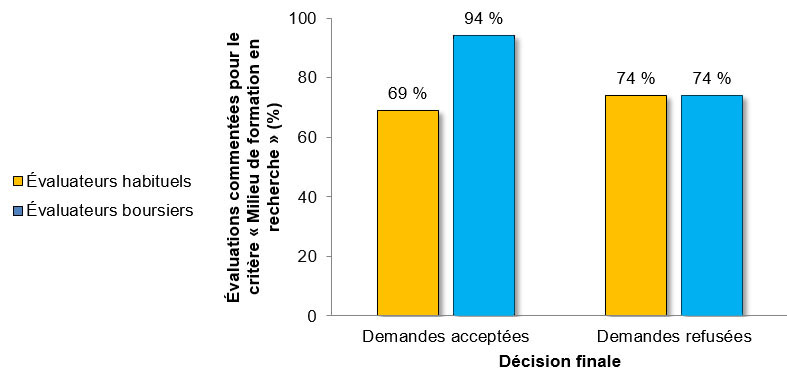

Demandes acceptées Demandes refusées Évaluateurs habituels (N = 35) Évaluateurs boursiers (N = 35) Évaluateurs habituels (N = 35) Évaluateurs boursiers (N = 35) Nombre d’évaluations concernées 20 25 18 25 % de leur catégorie 57 % 71 % 51 % 71 % La figure 11 indique le pourcentage des évaluations dans lesquelles les évaluateurs habituels et les évaluateurs boursiers ont formulé des commentaires relativement au critère « Milieu de formation en recherche », pour les demandes acceptées et refusées.

Description détaillée de la figure 11

Nombre d’évaluations réalisées par les évaluateurs habituels et les évaluateurs boursiers dans lesquelles on retrouve des commentaires pour le critère « Milieu de formation en recherche », pour les demandes acceptées et refusées, et pourcentage que représentent ces évaluations dans leur catégorie.

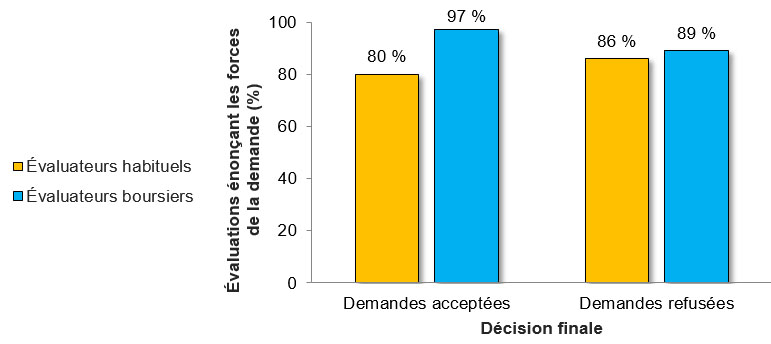

Demandes acceptées Demandes refusées Évaluateurs habituels (N = 35) Évaluateurs boursiers (N = 35) Évaluateurs habituels (N = 35) Évaluateurs boursiers (N = 35) Nombre d’évaluations concernées 24 33 26 26 % de leur catégorie 69 % 94 % 74 % 74 % Critère 3 : Mise en évidence des forces et des faiblesses

La figure 12 illustre le pourcentage des évaluations dans lesquelles les évaluateurs habituels et les évaluateurs boursiers ont énoncé les forces de la demande, pour les demandes acceptées et refusées.

Description détaillée de la figure 12

Nombre d’évaluations réalisées par les évaluateurs habituels et les évaluateurs boursiers énonçant les forces de la demande, pour les demandes acceptées et refusées, et pourcentage que représentent ces évaluations dans leur catégorie.

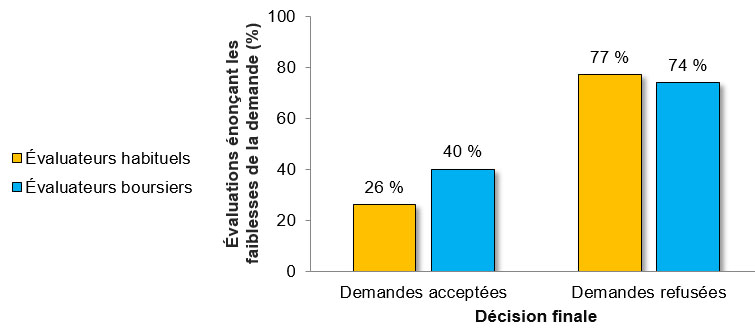

Demandes acceptées Demandes refusées Évaluateurs habituels (N = 35) Évaluateurs boursiers (N = 35) Évaluateurs habituels (N = 35) Évaluateurs boursiers (N = 35) Nombre d’évaluations concernées 28 34 30 31 % de leur catégorie 80 % 97 % 86 % 89 % La figure 13 indique le pourcentage des évaluations dans lesquelles les évaluateurs habituels et les évaluateurs boursiers ont énoncé les faiblesses de la demande, pour les demandes acceptées et refusées.

Description détaillée de la figure 13

Nombre d’évaluations réalisées par les évaluateurs habituels et les évaluateurs boursiers énonçant les faiblesses de la demande, pour les demandes acceptées et refusées, et pourcentage que représentent ces évaluations dans leur catégorie.

Demandes acceptées Demandes refusées Évaluateurs habituels (N = 35) Évaluateurs boursiers (N = 35) Évaluateurs habituels (N = 35) Évaluateurs boursiers (N = 35) Nombre d’évaluations concernées 10 14 27 26 % de leur catégorie 26 % 40 % 77 % 74 % B. Utilité, définie comme la présence de conseils

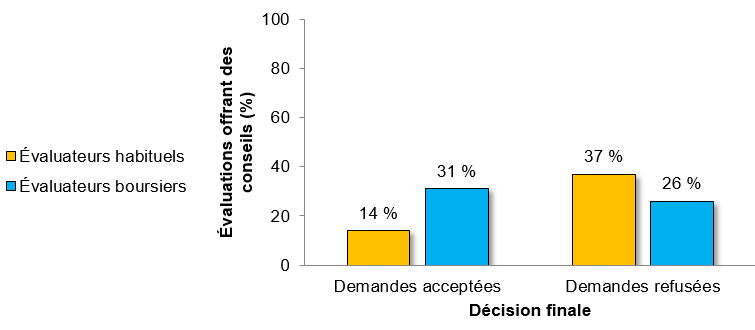

La figure 14 indique le pourcentage des évaluations dans lesquelles les évaluateurs habituels et les évaluateurs boursiers ont offert des conseils aux candidats, pour les demandes acceptées et refusées.

Description détaillée de la figure 14

Nombre d’évaluations réalisées par les évaluateurs habituels et les évaluateurs boursiers offrant des conseils aux candidats, pour les demandes acceptées et refusées, et pourcentage que représentent ces évaluations dans leur catégorie.

Demandes acceptées Demandes refusées Évaluateurs habituels (N = 35) Évaluateurs boursiers (N = 35) Évaluateurs habituels (N = 35) Évaluateurs boursiers (N = 35) Nombre d’évaluations concernées 5 11 13 9 % de leur catégorie 14 % 31 % 37 % 26 % -

C. Comparaison de l’expérience d’évaluation par les pairs – Analyse des résultats du sondage de suivi

Après le concours, un sondage a été mené auprès de tous les évaluateurs de demandes de BRD 2016 et 2017 pour évaluer leur expérience et faire ressortir les réussites et les défis du projet pilote d’évaluation par les pairs. Les boursiers postdoctoraux des projets pilotes 1 et 2 qui ont répondu au sondage ont affirmé qu’ils ont profité de l’exercice et qu’ils souhaiteraient acquérir davantage d’expérience. Les boursiers postdoctoraux des projets pilotes 1 et 2 ont également affirmé qu’ils s’étaient sentis prêts après avoir étudié le guide d’évaluation et les documents de formation des IRSC.

Le tableau 5 compare les données sur la participation au sondage dans les deux groupes d’évaluateurs :

Projet pilote 1 Projet pilote 2 Habituels Boursiers (BPB) Total Habituels Boursiers (BPB +MFE) Total Nombre total d’évaluateurs 191 47 238 200 50 250 Nombre total de répondants au sondage 83 25 108 90 40 130 Taux de réponse 43 % 53 % 45 % 45 % 80 % 52 % Les évaluateurs boursiers ont répondu aux questions suivantes :

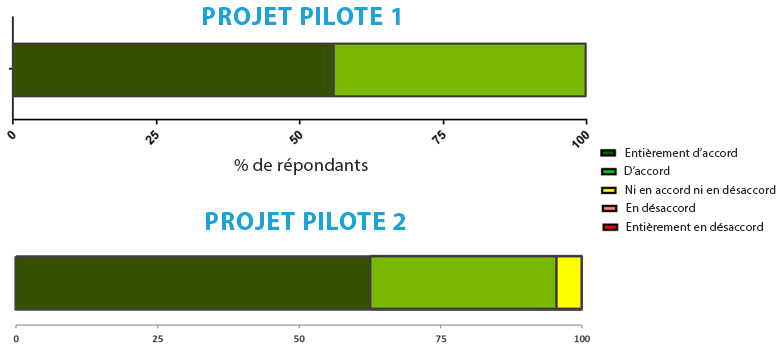

« Cette expérience d’évaluation par les pairs m’a aidé dans ma carrière comme chercheur (p. ex. préparation de demandes de subvention). »

Description détaillée de la figure 15

Réponse en pourcentage à la question d’opinion après le projet pilote d’évaluation par les pairs : « Dans quelle mesure êtes-vous d’accord avec l’affirmation suivante? Cette expérience d’évaluation par les pairs m’a aidé dans ma carrière comme chercheur (p. ex. préparation de demandes de subvention). »

- Projet pilote 1 : 100 % des répondants étaient d’accord avec l’énoncé, et plus de la moitié (56 %) étaient entièrement d’accord avec celui-ci.

- Projet pilote 2 : 95 % des répondants étaient d’accord avec l’énoncé, et plus de la moitié (63 %) étaient entièrement d’accord avec celui-ci.

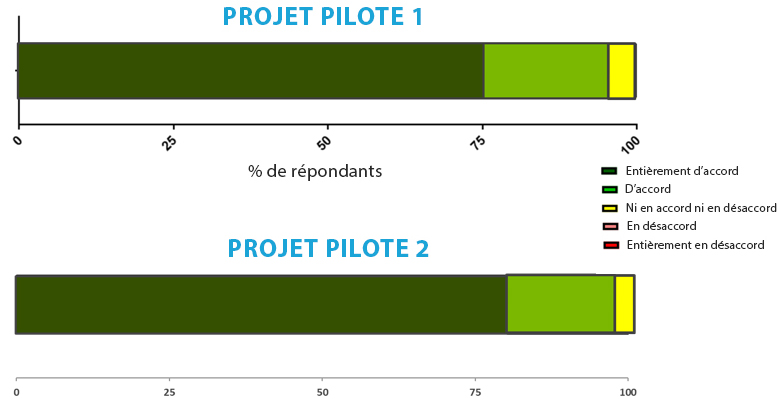

« Si l’on m’en donnait l’occasion, j’aimerais agir comme évaluateur à un concours des IRSC. »

Description détaillée de la figure 16

Réponse en pourcentage à la question d’opinion après le projet pilote d’évaluation par les pairs : « Dans quelle mesure êtes-vous d’accord avec l’affirmation suivante? « Si l’on m’en donnait l’occasion, j’aimerais agir comme évaluateur à un concours des IRSC. »

- Projet pilote 1 : Dans l’ensemble, 96 % des répondants étaient d’accord avec l’énoncé, et 76 % d’entre eux étaient entièrement d’accord avec celui-ci.

- Projet pilote 2 : Dans l’ensemble, 97 % des répondants étaient d’accord avec l’énoncé, et 80 % d’entre eux étaient entièrement d’accord avec celui-ci.

- Date de modification :